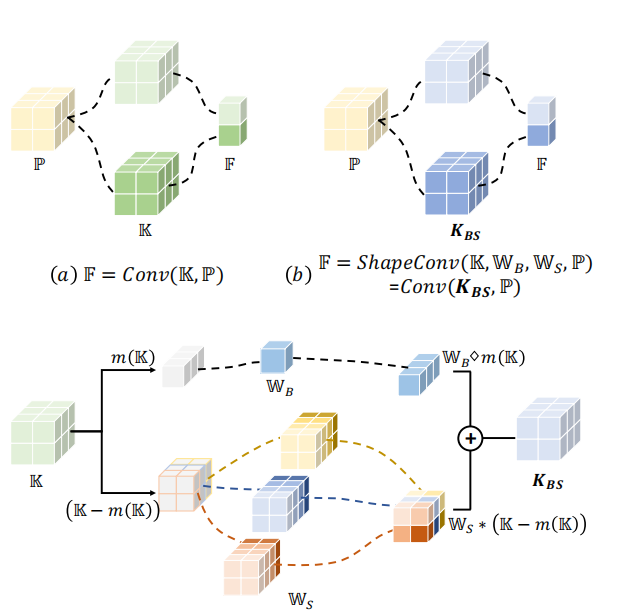

论文链接:ShapeConv: Shape-aware Convolutional Layer for Indoor RGB-D Semantic Segmentation 1 Why ShapeConv for RGB-D tasks 深度图包含物体的基础形状(局部信息,local geometry)和物体的位置(全局信息,在更大的contex…

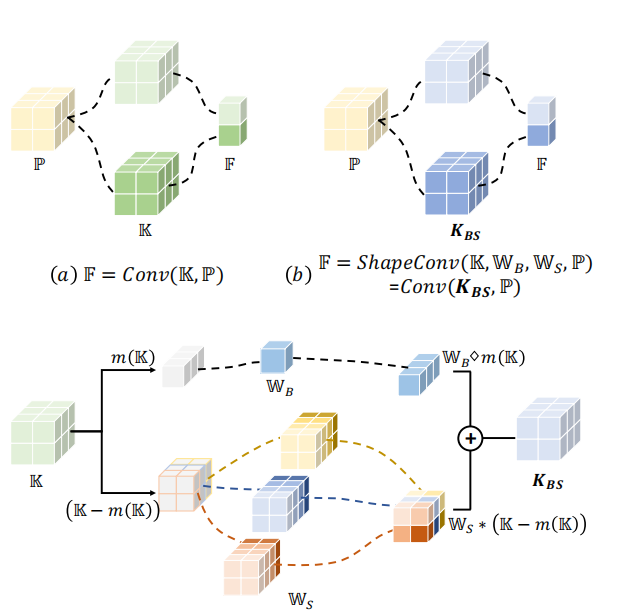

论文地址:Drop an Octave: Reducing Spatial Redundancy in Convolutional Neural Networks with Octave Convolution 1 Introduction 图片可以被分解为低空间频率和高空间频率的部分,它们分别描述缓慢变化的结构和剧烈变化的详细细节。作者认为卷积层…

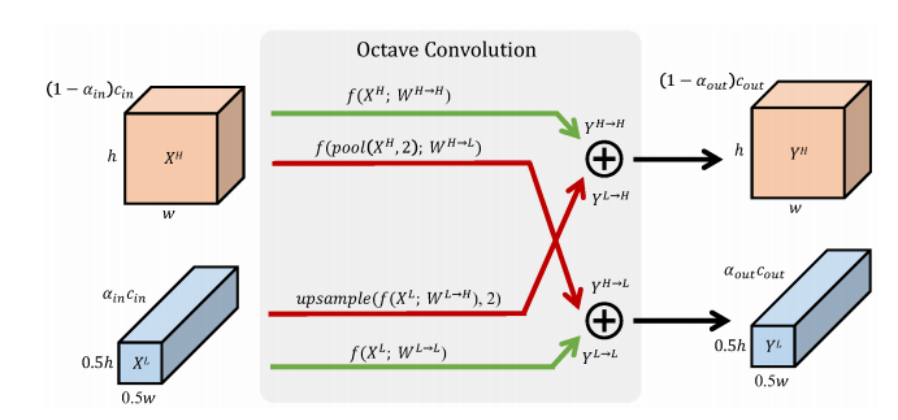

论文地址:ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks 1 Background ECA-Net是SENet的改进,SENet在计算C个通道的attention score的时候,使用的是单隐藏层的MLP: C->C/r->C,作者…

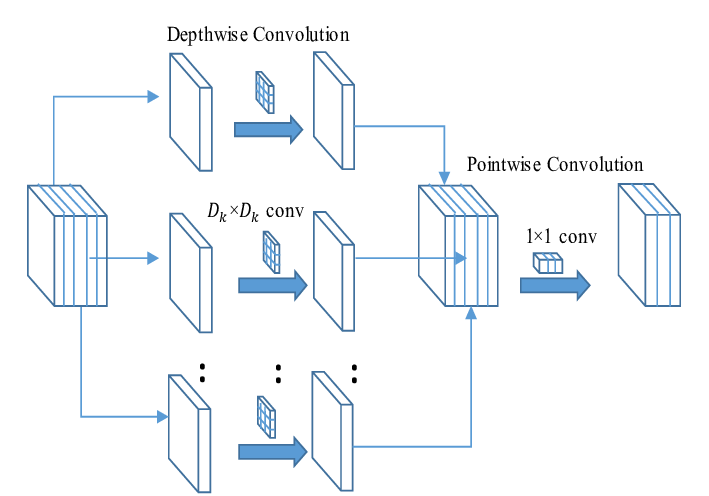

Depthwise Separable Convolution(深度可分离卷积)是将传统卷积分成两步进行计算即Depthwise和Pointwise。可以简化参数量和计算量,通常应用在轻量化网络中。 1 Depthwise Convolution Depthwise Conv和普通的卷积不同,Depthwise Conv的卷积核只有一个,其通道的数…

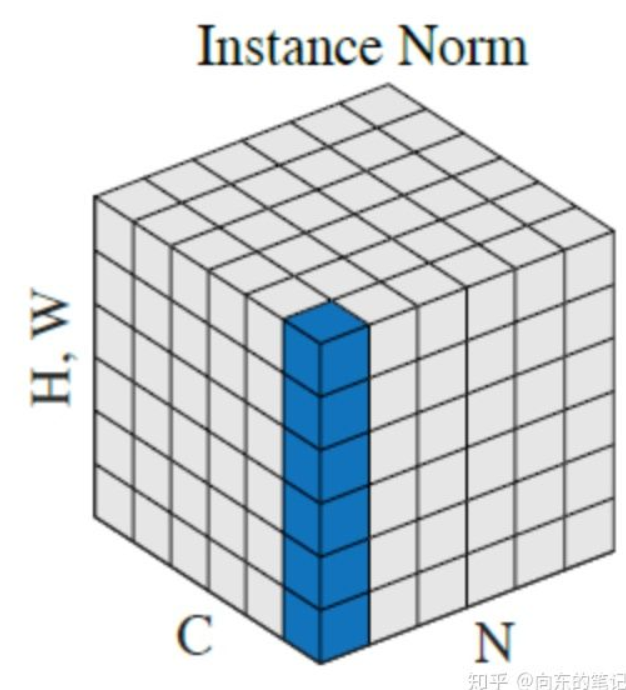

Instance Normalization(实例规范化,简称 IN)是一种在深度学习中使用的规范化技术,最初是为了图像风格转换任务而提出的。 1 规范化范围 IN是在单个样本(实例)的每个通道(每层特征)内进行规范化,独立于其他样本。 它对每个通道内的特征进行规范化,而不是跨整个批量(如BN)或整个层(如LN)。 2 计算过程 Instance …

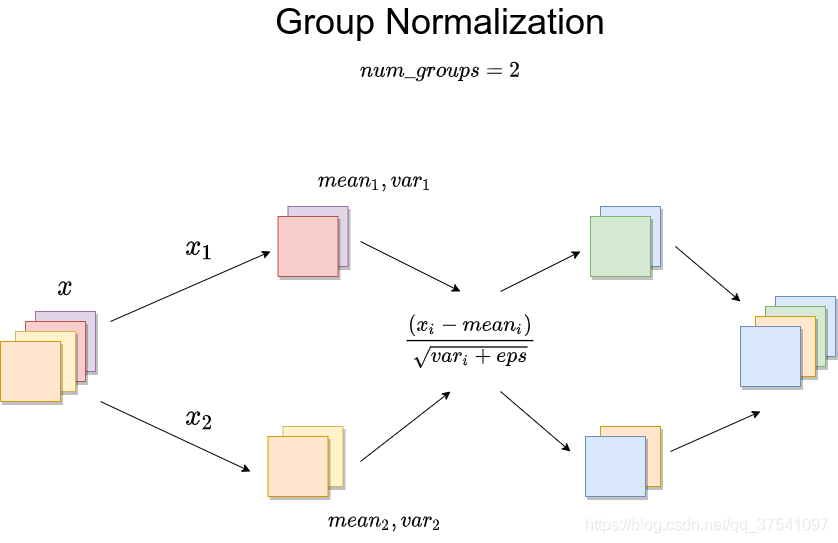

Batch Normalization,Layer Normalization 1 motivation 在视觉领域,其实最常用的还是BN,但BN也有缺点,通常需要比较大的Batch Size。如下图所示,蓝色的线代表BN,当batch size小于16后error明显升高(但大于16后的效果确实要更好)。对于比较大型的网络或者GPU显存不够的情况…

预备知识:Batch Normalization 1 Batch Normalization局限性 假设把中国的收入水平进行标准化(变成标准正态分布),这时中国高收入人群的收入值接近3,中收入人群的收入值接近0,低收入人群接近-3。不难发现,标准化后的相对大小是不变的,即中国富人的收入水平在标准化前和标准化后都比中国穷人高。把中国的收入水平看成一个…

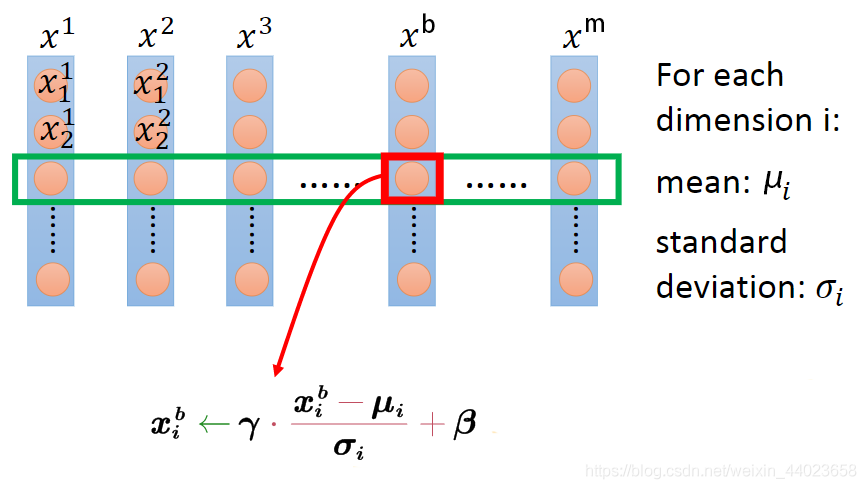

为什么要使用Batch Normalization? 使用浅层模型时,随着模型训练的进行,当每层中参数更新时,靠近输出层的输出较难出现剧烈变化。对深层神经网络来说,随着网络训练的进行,前一层参数的调整使得后一层输入数据的分布发生变化,各层在训练的过程中就需要不断的改变以适应学习这种新的数据分布。所以即使输入数据已做标准化,训练中模型参数的更新依然很…

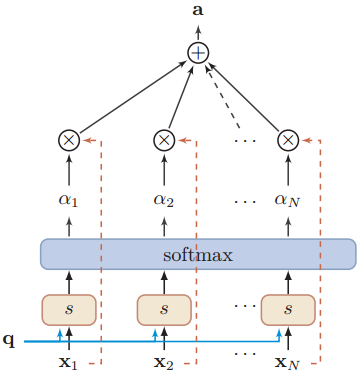

什么是注意力机制?给定一篇很长的文章,然后就此文章进行提问,提出的问题只和段落中的一两个句子相关,其余部分都是无关的,为了减小神经网络的负担,只需要把相关的片段挑选出来让后续的神经网络来处理,而不需要把所有文章都输给神经网络 1.计算感兴趣的输入向量 给定输入向量从\([x_{1},\cdots,x_{N}]\)中选出和某个特定任务相关的信息,需要…